Sztuczna inteligencja a rozwój bankowości

Sztuczna inteligencja stała się integralną częścią rozwoju bankowości. Zastosowanie AI w bankach pozwala na automatyzację procesów, wykrywanie nadużyć oraz dostosowywanie usług do indywidualnych potrzeb klientów. Technologie takie jak uczenie maszynowe czy analiza danych nie tylko przyspieszają operacje, ale również mogą przyczynić się do zwiększenia poziomu bezpieczeństwa.

Warto zauważyć, że według wyników raportu McKinsey Global Survey „The State of AI in 2023”, aż 75% firm z sektora finansowego planuje zwiększyć inwestycje w AI w ciągu najbliższych lat. To oznacza, że banki dostrzegają ogromny potencjał AI, ale równocześnie stoją przed wyzwaniem. Jak skutecznie zarządzać tą technologią, by była zgodna z nadchodzącymi przepisami?

AI Act – wyzwania dla sektora finansowego

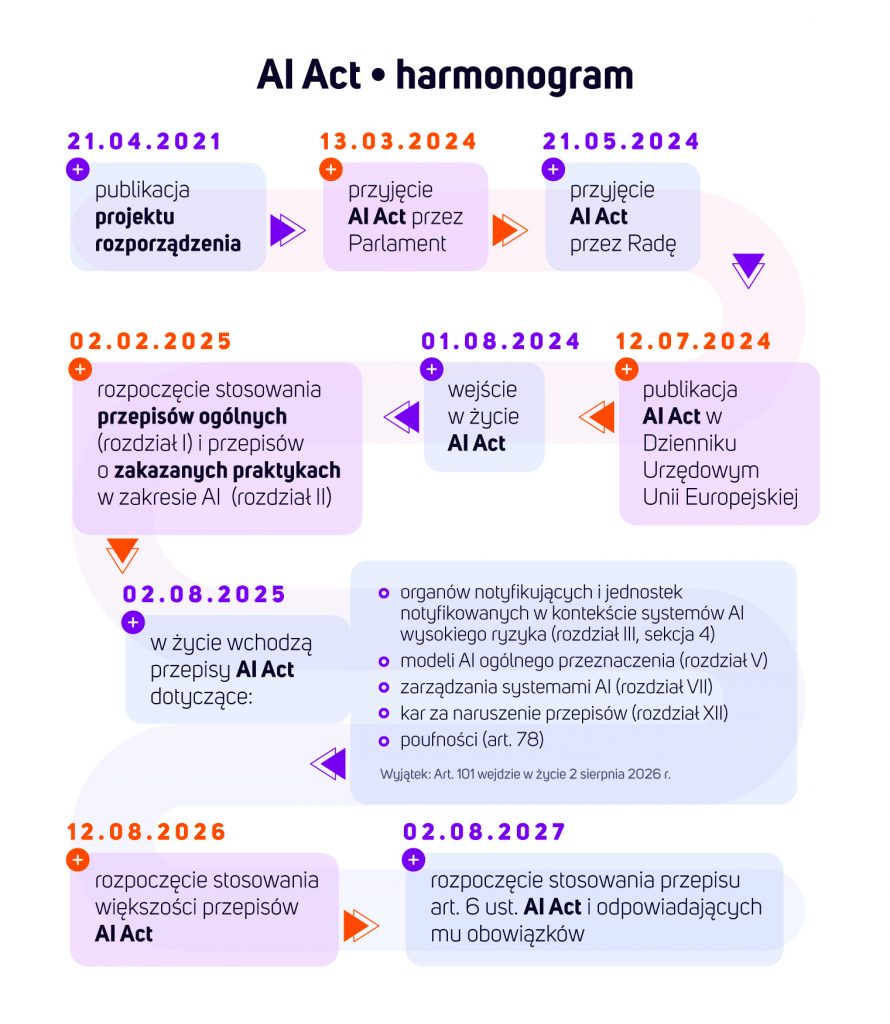

AI Act to rozporządzenie unijne, które wprowadza jednolite zasady dotyczące wdrażania i monitorowania systemów AI. W marcu 2024 roku Parlament UE przyjął jego ostateczną wersję. Te regulacje mają na celu ustanowienie jasnych zasad i standardów dla stosowania AI w Europie.

Czas na przygotowanie się do AI Act jest wyjątkowo krótki. Choć przepisy zaczną obowiązywać częściowo od sierpnia 2025, pełne wdrożenie planowane jest na luty 2026. To oznacza, że banki mają mniej niż dwa lata na przygotowanie się do nowych regulacji, które będą miały bezpośredni wpływ na wszystkie procesy wykorzystujące sztuczną inteligencję. W kontekście dużych organizacji, które muszą zmapować wszystkie modele AI, ocenić ich ryzyko, poprawić dokumentację i przeprowadzić odpowiednie audyty, ten czas jest bardzo ograniczony.

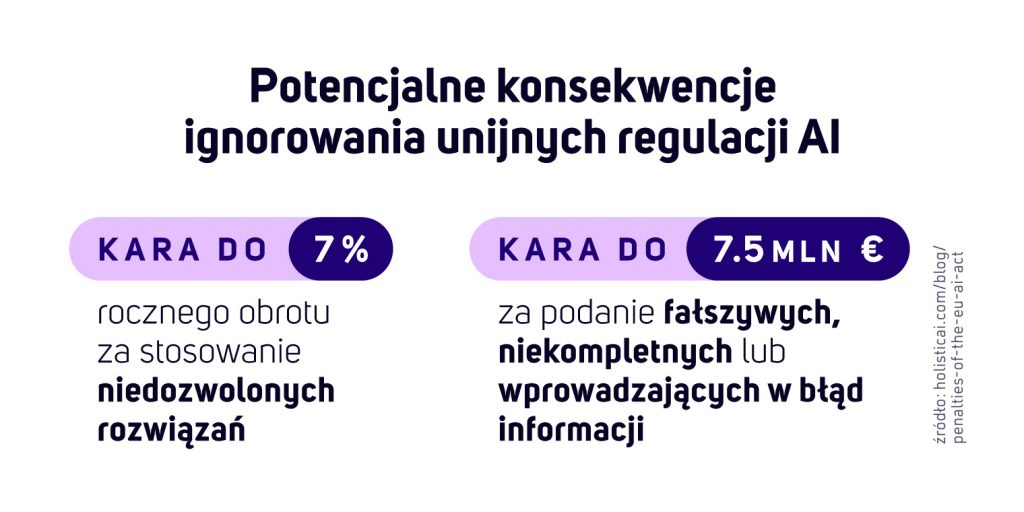

Według raportu EY Global Survey, aż 60% instytucji finansowych przyznaje, że nie jest w pełni przygotowana na nadchodzące przepisy związane z AI Act. To poważny problem, ponieważ brak odpowiedniego przygotowania na nadchodzące regulacje może prowadzić do surowych konsekwencji. Chaos operacyjny to jedno z głównych zagrożeń – banki mogą napotkać trudności z wdrożeniem projektów AI, a w najgorszym przypadku mogą zostać zmuszone do ich wstrzymania, by nie naruszyć prawa.

Ryzyko kar to kolejny istotny aspekt – jeśli instytucje finansowe nie przeprowadzą audytu swoich systemów AI, mogą zostać ukarane grzywnami lub innymi sankcjami finansowymi. Równie ważne jest ryzyko utraty reputacji. Regulatorzy mogą publicznie wskazywać przypadki naruszeń, co może poważnie zaszkodzić wizerunkowi banków.

Proaktywne podejście do AI Governance

Proaktywne podejście do wdrożenia AI Act to klucz do sukcesu. Lepiej zacząć działać teraz, opracowując plan dostosowania do nowych przepisów, niż czekać do ostatniej chwili. Jest to sytuacja podobna do wdrożenia RODO, kiedy to firmy, które wcześniej zajęły się politykami prywatności, przeszły przez proces gładko. Natomiast spóźnialscy zderzyli się z gorączkowymi przygotowaniami na ostatnią chwilę, tuż przed wyznaczonym terminem.

Nowe regulacje nakładają szereg obowiązków, takich jak:

- Kategoryzacja systemów AI – konieczność oceny, czy dany system jest klasyfikowany jako „wysokiego ryzyka”, co wymaga dodatkowej transparentności i zgodności.

- Nowe standardy bezpieczeństwa – AI w bankowości musi działać zgodnie z zasadami etyki, minimalizować ryzyko uprzedzeń algorytmicznych i zapewniać pełną audytowalność decyzji podejmowanych przez algorytmy.

- Dokumentacja techniczna i raportowanie – instytucje finansowe wdrażające AI będą zobowiązane do przechowywania szczegółowej dokumentacji technicznej oraz raportowania regulatorom.

- Przejrzystość algorytmów – wymaganie, aby decyzje podejmowane przez AI były zrozumiałe i weryfikowalne, co ma przeciwdziałać tzw. „czarnym skrzynkom” (black-box AI).

- Monitorowanie ryzyka – obowiązek prowadzenia analiz ryzyka związanego z wdrożonymi systemami AI i ich potencjalnym wpływem na użytkowników.

Zakazane systemy AI

W ramach AI Act, Unia Europejska nakłada restrykcje na pewne praktyki AI, które stanowią zbyt duże ryzyko dla społeczeństwa i jednostek, zakazując ich stosowania w obrocie.

Do zakazanych systemów AI należą te, które wykorzystują techniki manipulacyjne lub oceniają ludzi w sposób dyskryminujący. Przykładem może być manipulacja behawioralna, gdzie AI w sposób podprogowy wpływa na decyzje człowieka, np. skłaniając go do zakupu produktu, o którym nie był wcześniej przekonany.

Innym zakazanym przypadkiem jest wykorzystywanie wrażliwych cech ludzi, takich jak wiek, niepełnosprawność, pochodzenie etniczne czy orientacja seksualna, w sposób, który prowadzi do manipulacji lub dyskryminacji. W kontekście banków, oznacza to, że instytucje finansowe nie mogą wykorzystywać AI do oceny swoich klientów na podstawie danych niezwiązanych z ich sytuacją finansową, np. odmawiać kredytu osobom z określonymi nawykami społecznymi.

Mimo, iż banki mogą korzystać z AI do personalizacji usług, np. w zakresie rekomendacji produktów, muszą jednak unikać jakichkolwiek działań, które mogą być postrzegane jako manipulacja.

Przykładem granicy jest sytuacja, gdy AI wywołuje określone emocje u klienta, aby skłonić go do zakupu. Ważne jest, aby przy wykorzystywaniu AI przestrzegać zasad etycznych, traktując klienta z pełnym szacunkiem i przejrzystością.

Znaczenie etyczne tych przepisów jest kluczowe. Nawet jeśli banki nie są bezpośrednio zaangażowane w stosowanie zakazanych systemów, mogą one znaleźć się w sytuacji, gdzie ich rozwiązania marketingowe lub scoringowe naruszają granice etyczne. AI Governance musi więc szczególnie dbać o to, aby żadne z zastosowanych narzędzi nie wpływały na klientów w sposób, który naruszałby ich prawa.

Co trzeba zrobić, aby zaufać decyzji podjętej przez AI?

Aby zaufać decyzji podjętej przez AI, należy zadbać o kilka kluczowych aspektów. Trzeba zapewnić nie tylko zgodność z wymaganiami prawnymi, ale także zbudować zaufanie użytkowników.

- Pierwszym elementem jest wyjaśnialność (Explainability) – AI nie może być czarną skrzynką. Musimy rozumieć, dlaczego model podjął określoną decyzję. W banku oznacza to, że klient czy pracownik musi mieć możliwość uzyskania wyjaśnienia, np. dotyczącego decyzji kredytowej.

- Kolejnym filarem jest uczciwość (Fairness) – czyli unikanie biasu i dyskryminacji. Modele muszą traktować różne grupy sprawiedliwie, a wszelkie różnice muszą być merytorycznie uzasadnione.

- Ważnym aspektem jest także odporność (Robustness) – AI powinno być stabilne, nawet gdy napotka nowe, nieoczekiwane sytuacje. Na przykład, zmiana w danych czy próby manipulacji danymi wejściowymi.

- Aby zapewnić wiarygodność, konieczna jest także transparentność (Transparency), czyli pełna jawność procesu tworzenia i wdrażania modeli AI. Użytkownicy muszą być świadomi, jak ich dane są wykorzystywane i na jakiej podstawie podejmowane są decyzje.

- Wreszcie, kluczową rolę odgrywa prywatność (Privacy), czyli ochrona danych użytkowników. Modele muszą być zgodne z przepisami ochrony danych osobowych, np. RODO, oraz dbać o to, by dane klientów nie były narażone na wyciek czy niewłaściwe wykorzystanie.

Także, ciągłe doskonalenie modeli jest niezwykle ważne. Wdrożenie sztucznej inteligencji to proces, który wymaga ciągłego monitorowania i adaptacji do zmieniających się warunków rynkowych.

AI Governance – jak banki mogą zapewnić zgodność z regulacjami?

AI w bankowości niesie za sobą ogromny potencjał, ale wymaga odpowiedzialnego zarządzania. Trzeba dbać o to. aby zapewnić zgodność z nowymi regulacjami, bezpieczeństwo oraz etykę. Przygotowanie do AI Act to kluczowy krok, który pozwoli uniknąć ryzyka związanego z nieprzestrzeganiem przepisów.

IBM watsonx.governance – bezpieczne zarządzanie AI

W kontekście nadchodzących regulacji, instytucje bankowe muszą wdrożyć skuteczne mechanizmy nadzoru nad sztuczną inteligencją. IBM watsonx.governance to platforma stworzona przez IBM, która pozwala na pełną kontrolę i zgodność systemów AI z wymaganiami prawnymi i etycznymi. Pomaga ona zapewnić:

- zgodność – łącząc dane z kontrolą ryzyka i zbierając metadane modelu do audytów, wspiera przejrzystość AI, zgodność z politykami oraz standardami,

- zarządzanie ryzykiem – umożliwia monitorowanie wydajności, ochrony danych i innego ryzyka, które może mieć wpływ na instytucję finansową,

- zarządzanie cyklem życia – ułatwia nadzorowanie predykcyjnych modeli ML oraz modeli generatywnej sztucznej inteligencji przez pełny cykl życia, dostarczając przepływy pracy i monitorując zadania.

Dowiedz sie wiecej o platformie watsonx.governance tutaj.

Wkrótce na naszym blogu pojawi się kolejny artykuł. Szczegółowo omówimy wyzwania związane z zarządzaniem dużymi modelami AI oraz ich efektywną kontrolą w ramach AI Governance.

Dowiedz się więcej o tym, jak dostosować swoją organizację do nowych wymogów AI Act – skontaktuj się z nami!